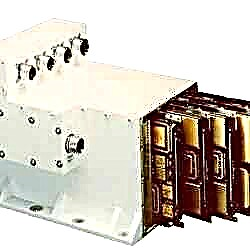

Komputery EAFTC w podwoziu lotniczym z przestrzenią. Źródło zdjęcia: NASA / Honeywell. Kliknij, aby powiększyć

Niestety promieniowanie przenikające przestrzeń kosmiczną może powodować takie usterki. Kiedy cząstki o dużej prędkości, takie jak promienie kosmiczne, zderzają się z mikroskopijnym obwodem układów komputerowych, mogą powodować błędy. Jeśli te błędy spowodują, że statek kosmiczny odleci w złym kierunku lub zakłóci system podtrzymywania życia, może to być zła wiadomość.

Aby zapewnić bezpieczeństwo, większość misji kosmicznych korzysta z odpornych na promieniowanie układów komputerowych. „Rad-hard” chipy pod wieloma względami różnią się od zwykłych chipów. Na przykład zawierają dodatkowe tranzystory, które wymagają więcej energii do włączania i wyłączania. Promienie kosmiczne nie mogą ich tak łatwo uruchomić. Rad-hard chipy nadal wykonują dokładne obliczenia, gdy zwykłe chipy mogą się „popsuć”.

NASA opiera się prawie wyłącznie na tych wyjątkowo wytrzymałych układach, aby komputery zajmowały dużo miejsca. Ale te niestandardowe układy mają pewne wady: są drogie, energochłonne i powolne - nawet 10 razy wolniejsze niż równoważny procesor w nowoczesnym stacjonarnym komputerze stacjonarnym.

Gdy NASA wysyła ludzi z powrotem na Księżyc i na Marsa - zobacz Wizję eksploracji kosmosu - planiści misji z przyjemnością zwiększą moc obliczeniową swojego statku kosmicznego.

Posiadanie większej mocy obliczeniowej na pokładzie pomogłoby statkom kosmicznym zaoszczędzić jedno z ich najbardziej ograniczonych zasobów: przepustowość. Przepustowość dostępna dla przesyłania danych z powrotem na Ziemię jest często wąskim gardłem, a prędkości transmisji są nawet wolniejsze niż w przypadku starych modemów telefonicznych. Gdyby ryz surowych danych zebranych przez czujniki statku kosmicznego można było „załamać” na pokładzie, naukowcy mogliby przesłać tylko wyniki, które zajęłyby znacznie mniejszą szerokość pasma.

Na powierzchni Księżyca lub Marsa odkrywcy mogą używać szybkich komputerów do analizowania swoich danych zaraz po ich zebraniu, szybkiego identyfikowania obszarów o dużym znaczeniu naukowym i być może gromadzenia większej ilości danych przed upływem przelotnej okazji. Również łaziki skorzystałyby na dodatkowej inteligencji współczesnych procesorów.

Korzystanie z tych samych niedrogich, potężnych układów Pentium i PowerPC, które znajdują się w komputerach konsumenckich, pomogłoby ogromnie, ale aby to zrobić, należy rozwiązać problem błędów wywołanych promieniowaniem.

W tym momencie pojawia się projekt NASA o nazwie Environmental Adaptive Fault-Tolerant Computing (EAFTC). Naukowcy pracujący nad projektem eksperymentują ze sposobami wykorzystania procesorów konsumenckich w misjach kosmicznych. Są szczególnie zainteresowani „zdenerwowaniem pojedynczego zdarzenia”, najczęstszym rodzajem usterki powodowanej przez pojedyncze cząstki promieniowania wbijające się w wióry.

Członek zespołu Raphael Niektórzy z JPL wyjaśniają: „Jednym ze sposobów użycia szybszych procesorów konsumenckich w kosmosie jest po prostu posiadanie trzy razy większej liczby procesorów niż potrzebujesz: trzy procesory wykonują te same obliczenia i głosują na wynik. Jeśli jeden z procesorów popełni błąd wywołany promieniowaniem, pozostałe dwa nadal się zgodzą, wygrywając w ten sposób głos i dając prawidłowy wynik. ”

To działa, ale często jest to przesada, marnowanie cennej energii elektrycznej i mocy obliczeniowej do potrójnych obliczeń, które nie są krytyczne.

„Aby to zrobić mądrzej i wydajniej, opracowujemy oprogramowanie, które waży wagę obliczeń”, kontynuuje Some. „Jeśli jest to bardzo ważne, jak nawigacja, wszystkie trzy procesory muszą głosować. Jeśli jest to mniej ważne, np. Pomiar składu chemicznego skały, może być zaangażowany tylko jeden lub dwa procesory ”.

To tylko jedna z kilkudziesięciu technik korekcji błędów, które EAFTC łączy w jeden pakiet. Rezultatem jest znacznie lepsza wydajność: bez oprogramowania EAFTC komputer oparty na procesorach konsumenckich potrzebuje 100-200% redundancji, aby zabezpieczyć się przed błędami spowodowanymi promieniowaniem. (100% redundancja oznacza 2 procesory; 200% oznacza 3 procesory). W EAFTC tylko 15-20% redundancji jest potrzebne dla tego samego stopnia ochrony. Cały zaoszczędzony czas procesora można zamiast tego produktywnie wykorzystać.

„EAFTC nie zastąpi twardych procesorów”, ostrzega Niektórzy. „Niektóre zadania, takie jak podtrzymywanie życia, są tak ważne, że zawsze chcemy, aby uruchomiły je chipy utwardzane promieniowaniem”. Ale we właściwym czasie algorytmy EAFTC mogą odciążyć niektóre procesory od obciążenia tych układów, dzięki czemu znacznie większa moc komputera będzie dostępna dla przyszłych misji.

Pierwszym testem EAFTC będzie satelita o nazwie Space Technology 8 (ST-8). ST-8, część nowego programu milenijnego NASA, przetestuje w locie nowe, eksperymentalne technologie kosmiczne, takie jak EAFTC, umożliwiając ich większą pewność w przyszłych misjach.

Satelita, którego start zaplanowano na 2009 r., Będzie przesuwał pasy promieniowania Van Allena podczas każdej ze swoich eliptycznych orbit, testując EAFTC w tym środowisku o wysokim promieniowaniu podobnym do kosmosu.

Jeśli wszystko pójdzie dobrze, sondy kosmiczne w całym Układzie Słonecznym mogą wkrótce używać dokładnie tych samych układów, które można znaleźć w komputerze stacjonarnym - tylko bez usterki.

Oryginalne źródło: NASA News Release